Physical Intelligence

Founded Year

2024Stage

Series A | AliveTotal Raised

$470MValuation

$0000Last Raised

$400M | 10 mos agoMosaic Score The Mosaic Score is an algorithm that measures the overall financial health and market potential of private companies.

+99 points in the past 30 days

About Physical Intelligence

Physical Intelligence works on the integration of general-purpose artificial intelligence into the physical world, with a focus on the robotics sector. The company develops foundation models and learning algorithms that allow robots and physically-actuated devices to perform complex tasks. The technology is aimed at improving the functionality of robots and devices using AI. It was founded in 2024 and is based in San Francisco, California.

Loading...

Loading...

Research containing Physical Intelligence

Get data-driven expert analysis from the CB Insights Intelligence Unit.

CB Insights Intelligence Analysts have mentioned Physical Intelligence in 3 CB Insights research briefs, most recently on Aug 26, 2025.

Aug 26, 2025 report

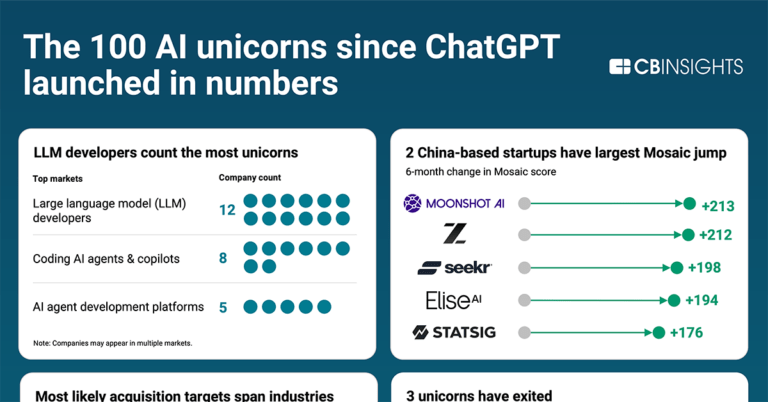

All 100 AI unicorns since ChatGPT launched

Feb 4, 2025 report

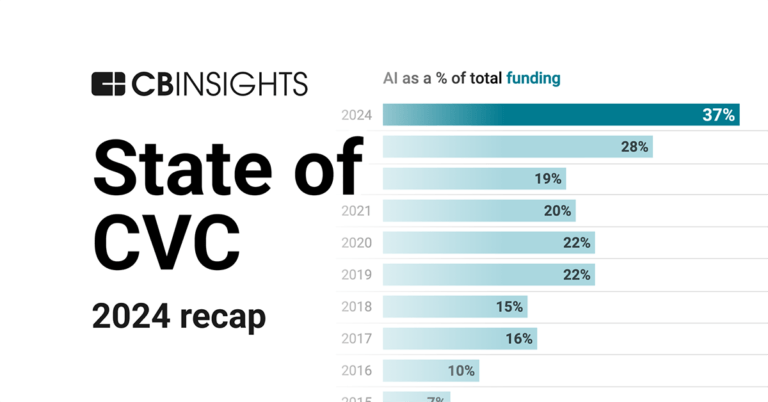

State of CVC 2024 ReportExpert Collections containing Physical Intelligence

Expert Collections are analyst-curated lists that highlight the companies you need to know in the most important technology spaces.

Physical Intelligence is included in 2 Expert Collections, including Artificial Intelligence.

Artificial Intelligence

10,402 items

Unicorns- Billion Dollar Startups

1,286 items

Latest Physical Intelligence News

Sep 12, 2025

所以在我探索大模型的途中,最大的一个惊喜发现就是,验证了模型的通用性,这样就可以开始做一些泛化、性能提升上的探索,这时才能开始讨论机器人大模型的可能性。在机器人领域,我觉得现在比起两三年前,对大模型这一种技术路线的信仰要浓厚得多。 王昊:今年有一个非常明显的现象,那就是在应用上呈现出了指数效应。这背后的驱动力,其实也是来源于通用机器人基础模型的发展和进步。 在2023年以前,我们很多人会专注在单个任务上,把它做到极致;但现在我们有了统一的基础模型之后,就能够同时学习并执行成百上千种不同的任务,其实也就意味着:我们的优化目标变了,重心放在了提升整个模型在所有任务上的平均成功率。这也是指数效应发展的基础,我们现在可以开始去做复杂的长程任务(Long-Horizon Task,包含一系列连续步骤、需要机器人进行多步推理、规划并执行,最终才能完成的复杂任务),这是一个非常令人惊喜的现象。 泓君:我总结大家刚刚的关键词,一个是整个机器人模型泛化的探索,还有一个是复杂的长任务。请帮我们举一些例子来说明下,比如有哪些任务机器人以前做不到,到了2025年就能做到了?或者以前机器人只能局限在某个场景的特定任务,现在可以迁移到其他的场景了? 图片来源:Physical Intelligence 大家一般认为让AI下围棋很难,因为围棋的复杂度很高嘛,每一把棋局都不一样,其实在我们日常生活中,叠衣服这些看上去对人来说很简单的小任务,它具体的复杂度也很高。比如衣服上面可能有两个折、有三个折,或者某个折的角度不一样,对机器人来说可能都是一个新的情况,它需要把这么多不同的情况解决。 同时叠衣服有很多不同的步骤,要先叠什么再叠什么,有这样的序列性,这种复杂的细分的情况和序列性,使得叠衣服这个任务在以前是比较难解决的。 到了2025年,我们也开始探索了不少泛化的方向,比如说把π₀.₅模型放到一个移动机器人里,再把这个移动机器人放到不同的、没有见过的家里,这些都不在模型的数据集里面,模型可能不知道会怎么反应,然后我们观察它会怎么做。在这个过程中我们发现,要做到泛化性还是比较有希望的,虽然机器人的表现不是很完美,但它好像展现出了一点像人类的特性,比如拿东西,换到别的家场景里还是能拿。 泓君:它拿的是哪一类的东西?在我的理解中,衣服是软的布,但如果拿起一个杯子、一个碗,是不是就不太一样? 柯丽一鸣:是的,其实这一类问题在机器人内部术语就叫抓取问题,因为它要结合物体具体的形状、摆放的位置,甚至你靠近过去的时候的角度来考量。 所以抓取问题是既简单又不简单的一个问题,比如你要抓一个水杯,就算是完全一样的水杯,在两个不同环境中,也是一种泛化的体现,需要的策略会不一样。甚至以后我告诉机器人要拿杯子,它不管去了一个新的家、拿了一个完全不一样的杯子,都要能完成,彻底的泛化结果就需要这样层层递进的测试。 图片来源:Physical Intelligence 柯丽一鸣:当我们在开始推进π₀.₅的时候,我们强调的点就是泛化,这时会强迫自己去收集一些不同的数据。但这个“不同”的数据的“不同”,其实没有那么好定义,因此我们决定把机器人放到外面不同的房子里去测试。 而在这个过程中我们又发现,不知道要收多少个不同的房子的数据才算到头了,我们得一边收集、一边检验,同时心里也会怀疑:今天收集了3个房子的数据,是不是就有帮助了?如果我们收集了30个都没有帮助,是不是就意味着这条路走不通? 但还好我们收集到了很多的不同的数据以后,最后训练出来的模型在验证时,确实发现它有比较强的泛化能力。也就是说π₀.₅在一些新的环境中的表现比以前更好了。当然并不是任意新环境都很好,目前还存在一些局限性,但大家还在慢慢地在感受和探索,未来落地时在性能上还有很多提升空间。 泓君:你们觉得机器人模型在研发过程中,泛化问题最难的环节是什么?比如是因为数据量比较小,还是算法的问题? 王昊:难点之一是物理世界中长尾效应的鲁棒性(robustness的音译,指事物可以抵御外部应力和影响并维持原有状态的自身性质),比如因为环境、光照产生了一些视觉误差。虽然可以通过用更好的传感器、更强的算力、更好的生成模型帮你做数据合成、数据增强,来缓解这些长尾效应,但真正的难点就是,现实时间有太多种可能性了,我们没法预测到所有可能的corner case(边角案例)。 图片来源:自变量机器人 另一个难点就是在长程任务上,很多微小的物理扰动会造成的各种微小误差,它会像滚雪球一样被放大,尾部的误差到最后,可能就直接导致了任务的失败。所以我们要解决的就是,怎么让模型解决这些没法在数据里包含的各种corner case,这个事的核心是要去构建一个能够理解物理常识、能够有物理直觉的模型基础,让模型能有空间的理解能力、推理能力。 所以这个问题的核心就是,我们要把机器人真实的数据、人类的视频数据等等都合在一起,让数据的规模更大、来源更丰富、质量更高、更多样,让机器人从这个学习过程中能够理解物理规律。但是这些和真实世界交互的高保真数据又是目前比较稀缺的,要得到这些数据并不意味着疯狂地在现实世界去采就行了,这件事情远比想象地更复杂,它不止是数据量的问题,还是数据工程、数据管线的问题,比如如何降低我们的数据采集成本。 柯丽一鸣:我也觉得难点挺多的,并不是只有一两个难点。王昊刚才说的长尾问题我觉得是难点之一。而从研究的角度来看,我认为是测试机器人模型的表现如何是很难的。 大家经常看到新闻里说,哪家公司开放了新的大语言模型,它在某个榜单上面变成了第一名。而在机器人界,过去数十年来,一直没有办法在真机世界中做出这么一个榜单。没有办法非常客观、公正、可重复地告诉你:在什么情况下,模型A比模型B的表现是要好的。 做这个榜单的难点就是一个模型,它可能在某些地方表现好、其他地方表现不好,你要包含多少种不同的情况呢?如果要有一些corner case的话,那可就无穷无尽了。同时如果你想做一个真机的榜单,还要考虑这些真机维护、细节、对于模型的表现会不会造成影响等等情况。 因此到现在,机器人整个业界在发表论文的时候,很多时候都是依靠自己,既作为作者、又作为一个测评官,“我现在开发了一套算法,我们觉得它在这个任务上比之前的一些方法要好一些”。 缺乏统一的评价机制使得具身智能领域的发展缓慢了一些,因为你真的很难去分辨模型A、模型B到底哪个好。理想的情况是评分高的模型表现非常明显的好,而真实世界是菜鸡互啄。你说在模型上做了一些数据、算法上的改动,那你怎么验证? 据我所知的话,业界里肯定有不少人在探索用模拟器,或者说一个第三方的、像打擂台一样的评测标准,我觉得这也是大家在这个难题上开始进行的一些探索。 图片来源:央视网 王昊:我觉得是比较困难的。这也是我们具身领域大家感到的一个难点和一个痛点。很难有一个统一的评测标准,可以让大家没有那么高成本、且比较公平地去评测模型。最好的评测就是要到现实世界去评测,但是我们又很难搭建一个公平的决斗场,所以这个是比较困难的地方 但我觉得还是有些办法可以去评测的。比如说我们有一批开源模型,大家可以在自己的机器人本体上,去看不同的模型在学习相同的任务的时候所需要的数据量,它所展现出来的泛化能力、推理能力,是可以去评测的。那另外对于不同的机器人的公司,那可能合理且公平的是:我们把它的机器人应用到具体的场景里面,去看不同模型的表现怎么样。因为在真实世界运用时,它所展现出来这种多样性、泛化性或者环境是非常随机的,所以它是最能体现你模型能力的。 02 数据挑战与硬件瓶颈 所以我会觉得,什么时候我们能够收到100万小时,等同于一个人一生的物理经验的数据,可能才能开始后面的探索。之后如果真的能把机器人广泛地部署在真实世界中的话,那也许收100万小时的数据,也就是几天的时间。 这也是来自于和一些做语言、图像、音频生成的朋友的吐槽,因为他们动手就很豪气的:我今天要做这个任务,给我来400万小时的数据,明天就要收集,后天就要清洗,我就说,咱做了多少年机器人,好像都没这个400万这个量呢。 图片来源:Physical Intelligence 柯丽一鸣:我有一些很粗糙的想法,我们PI自己在做研究的时候,有个重心叫做跨本体迁移,就是希望在不同形状、不同类别的机器人上收集的数据,能适用到别的机器人上,让它更快地学会一个任务。 人类能做到这点可能和基因、躯体有一些关系,毕竟人类有一个非常好用的感知器,就是眼睛,现在也没有哪个相机敢对标人眼,还有我们的关节,这些物理的、天生的东西,我觉得是人行动力的基石。 我个人比较相信,可以用一些算法上的优势,去盖过硬件上的不足。但罗马不是一天建成的,咱也不能指望机器人马上就能像宝宝一样学得这么快。机器人如果要快速学习新任务的话,它之前还是得有非常多的积累。刚才王昊也提到、并且我在PI也看到的一点就是:某个机器人上收的一些任务数据,是可以帮助其他任务做得更好的,让新的任务也许就不用那么多数据。 王昊:其实和人比的话,我觉得对机器人来讲还是太不公平,核心就是因为人其实有“预训练”的。整个生物界在大规模的进化过程中,有两个非常核心的点:一是在进化过程中,人积累了很多先前验证的东西,比如跟世界交互的认知,关于物理世界的应对的策略,这些其实都写到了基因里;另一方面,人其实在不停地进化自己的硬件,整个生物界都是这样,大家能不用“智能”解决的东西,就尽量用“硬件”解决,所以很多生物体都会进化出一些结构,比如说大肠杆菌,它就不用长眼睛,只要对有化学、温度敏感的一些感知,就可以去适应周围的环境。 我们现在正在做事,就是帮助机器人做它的预训练模型,虽然看起来要覆盖人类进化的几亿年的时间,但其实也不太一样。第一是因为机器人是可以进行大规模复制的,不同机器人之间可以共享它们的经验,我们就可以快速构建机器人的预训练模型,让它能够具备对物理世界的感知、理解能力。当然这个过程也是让机器人越来越熟悉自己的身体,就像刚才Kay说的“跨本体泛化”,我们就是让不同的机器人(模型),适应不同的身体,并且让它能够互相感知到身体的不一样,这个很重要。 其次在人的学习里面,所谓1万小时理论还是有很多不一样。人并不是一定时间内专门去学这一个任务,学完了再学下一个新任务。你开始教宝宝去做某件事情的时候,比如说拿一个东西,他可能精确度也不够、抓不准,所以就把这个东西扔到一边就不管了,去玩别的玩玩具、搭积木什么的,而过一个月之后你会发现,拿东西这个任务他在并没有花多少时间学习,但是他已经会了,这也体现了人在后天和环境交互过程中学习,其实也是一个多任务并行的学习。它可以从不同任务中学习到这种底层的、共同的物理结构,这种共同物理结构就会帮助它学习新任务时,减少它所需的数据量。 所以现在我们训练机器人时也是这么做的,我们用尽可能多样的数据、覆盖各种能力的任务,去构建这个大的数据体系、构建机器人能力,它也许在学习新的任务的时候,需要的数据量就会大大减少。所以刚才说机器人需要百万小时数据,核心就是解决两个问题,第一是覆盖过去人类长时间进化这个预训练的过程,我们需要通过多样的数据,去帮助机器人构建这种基础能力。第二就是在学习新任务的时候,我们也要利用它在旧任务学习中,形成的这种通用能力,让他能够泛化到新能力上。所以在数据上、时间长度上不能完全类比人类,但我觉得这个学习历程和背后所反映的规律可能是一致的。 图片来源:自变量机器人-已开源的具身智能基础模型WALL-OSS 柯丽一鸣:在π₀的时候,我们做了一个比较简单的统计:π₀使用的数据,比谷歌研究院收集的所有数据加还要多,即使π₀发表的时候,PI还是一个很年轻的初创企业。 我觉得其实这是说明了两件事:第一就是那个时间点采集的数据量确实是非常大,而且之后一直有往里面增加数据,而数据的成本、数据的量是在实时变化的。在谷歌研究院在开始探索的时候,要花很大的功夫才收到这些数据,但后来渐渐的有了经验,PI或者其他公司再收就会越来越简单,成本应该也是能够得到控制和降低的。 泓君:那你们现在合成数据用的多吗?我知道业界很多都会用合成的数据,前几周谷歌发布了Genie 3世界模型,我听到了两派不同的观点:有一派认为的Genie 3对机器人有非常大的帮助,因为这种世界模型的数据是有用的,但是另一派就会觉得这个数据质量还是不够好。 图片来源:Google 王昊:我们是持续地发扬开源精神,也吸收了很多经验,所以是用了大概几万小时的真实世界的数据,训练了一个具身的基础模型。 我们是在一个统一的框架下面,让它可以既可以去做思维链、也可以做动作的生成。我们基于已经训练好的基础的视觉语言模型去做扩展,让它具备比较强的视觉理解、空间推理、多语言的指令遵循能力,同时它的动作的生成精度也比较高。这是我们观察到的,目前具身的开源模型上还比较欠缺的一些能力,我们也希望这次开源能够对具身智能行业有比较好的补充,让大家可以更好地用我们的基础模型,去做一些长程任务、解决一些复杂任务。 要解决这些长程任务,就需要更好的语言遵循、更好的空间以及因果的推理,也希望我们这种端到端的推理、规划加动作的执行模型,可以发挥作用,被社区用起来。 泓君:所以你们模型主打的点是什么?我觉得行业里面做模型玩家们,方向都还挺不一样的,比如有些是专注在精细的操作上的,像谷歌就很擅长于折纸的这些动作,像PI是希望有更强的泛化能力。如果用一句话去总结你们的优势,你觉得你们在机器人领域最关注的点是什么? 王昊:我们最关注的点是机器人的泛化和它的长程任务的解决能力。解决长程任务就意味着,它一定得有比较强的泛化能力,因为解决任何一个长序列的任务,它背后面临的都是变化的场景,这个任务可能遇到各种失败情况、各种没见过的操作对象,所以都需要它有很强的泛化。 泓君:比如那些长而复杂的问题,请大家举一个例子。 图片来源:自变量机器人-已开源的具身智能基础模型WALL-OSS 王昊:其实我们在现实中把机器人用到任何一个场景,都是长而复杂的。比如我要完整地把一个餐桌收拾好,它就是一个长而复杂的任务,因为你要操作对象的种类很多:你可能有硬的东西的操作,比如说餐具;也有一些液体需要去操作,比如把食物残渣、流体倒到固定的地方;你还可能有很多不规则物体的处理,比如说垃圾、残留物;有很多柔性的东西需要去处理,比如说擦桌子,折叠毛巾等等;可能需要把不同的东西放在不同的位置、还要比较小心地去处理可能洒出来或者其他的情况。 所以在收拾餐桌这个任务中,它执行起来并没有固定的顺序,说先做什么、后做什么,都是在一个长程任务里面,把各种子任务给穿插起来。人其实很难划分每个任务的边界是什么,这种任务就得靠模型端到端自主去决策、实时去规划,把整个任务完全做完的。 泓君:那在你们实验室里面,评测机器人任务做得如何时,实际训练是什么样的场景? 王昊:我们实际训练虽然也包含了其他的一些场景,但还是以家庭的场景为主,因为家庭场景其实基本上已经包含了具身智能需要解决的所有任务。像收拾整个餐桌、布置餐具、收拾整个卫生间、收拾房间,这些都是我们的训练任务,我们也实实在在地看到,机器人在处理这些长序列的闭环任务时,体现出来了操作能力、泛化能力的进步,这点确实让我们的信心大增。我们也希望能借助自变量的开源模型,让大家看到现在的基础模型,在解决长程任务这种泛化场景的时候所体现出来的能力。 03 模型架构与技术路径 泓君:我注意到不管是PI还是自变量,都是在做开源模型,为什么大家想做开源?开源对整个生态的好处是什么? 柯丽一鸣:我觉得能和业界、社区分享一下模型,并且能够帮助到大家很快地上手,可能也是在变相地降低机器人模型研究的一个入门门槛吧。其实在公司内部,开源也是一种(研发的)过程,就是从决定要开源,然后抽调大家把刚刚发表的研究去重构代码,然后做测试,再和社区的一些开发者沟通看能不能跑得起来。这是一项不简单的工作,但是真的看到我们的模型,在一些我们自己都没想到的机器人上面跑起来了、别人能用我们的模型做很多不同的实验,还是很开心的,现在大家都很乐意去开源,我觉得是很好的氛围。 图片来源:X.com 王昊:我一直都觉得开源是非常重要的事情,开源意味着我们可以站在巨人的肩膀上继续前进。我们可以基于已有成果做更多的改进,社区开发者的反馈也会帮助到开源的公司,开源公司可以从中吸取到经验,然后把这个技术路线思考得更加深入。一般的高校、或者一些小型的企业,他们可能没有能力去做基础模型,但是如果能够使用这些基础开源模型,他们就可以去做应用,把它用到各个方向,丰富整个生态,这也是一个非常重要的事情。 AI 的研究我觉得跟大模型之前有很大不一样。过去,我们可以看到AI和大模型的研究是非常离散的,在真正形成一个社区之前,可能做研究的只有两、三个人,大家疯狂地研究一个算法,更多是以论文发表作为第一要务,目的是占据技术的主动权。但有了社区和整个开源体系之后,大家更在乎的是,怎么在一个工程化的体系下,把这个工程基础打好,让这个社区更加繁荣?个人是通过什么方式给社区做贡献?大家的荣誉反而来自于这样的事情。这样也就会促使开源模型的技术不停地发展。所以我觉得开源是一个非常好的事情,既可以从中学习到新的东西,也可以看到你的东西可能对别人帮助。 泓君:大家觉得现在模型公司在判断一个模型好坏的核心因素是什么?现在大家不仅在拼各自采集的数据质量,同时在模型层可能有非常多不一样的技术路径,比如说是不是用高频控制的方式,是不是用 system 2+system 1的两个system的架构?大家可以聊一下模型层上不同的技术路径,以及你们看好的方式? 图片来源:自变量机器人-开源具身智能基础模型WALL-OSS 但是从另外一方面来讲,你都端到端训练了,那模型可以做得很大,可以做到几百亿、千亿的矩阵模型,那真正要去使用的时候怎么办?不可能在端侧需要非常高频控制去部署这么大模型,所以在推理的时候,我们反倒觉得模型是可以分开的,可以把更慢的任务过程可以放在云端去处理,更快的任务过程放在物理端侧,再由梯度回传更新整个系统参数,这个过程是非常非常重要的。 泓君:我们说其实两层架构的模型,它有一点点类似于人脑的大脑跟小脑,比如说有一层负责理解与规划,还有一层就是负责高频输出的控制,就像大脑去掌管认知跟决策,小脑去掌管运动控制。为什么你们不用这样的一个架构? 王昊:我们是一种端到端的训练,很难在模型内部把某些参数完全分成system 2,比如把某些系统分成快系统、直觉系统等,但是我们可以训出一个非常大的端到端模型,它可以具备非常强的具身通用能力,让具身的通用能力既包含理解推理,也包含动作生成。 但你实际在部署的时候可以有很多方式,比如把擅长动作部分给蒸馏压缩出来,然后擅长语言推理、视觉推理的部分给它放在云端等等。利用类似的方式部署,在推理过程中做很多优化,但训练的时候它还是一个统一架构。 泓君:就是推理跟控制在训练的时候是在一起的。那Kay你们是怎么做的? 泓君:所以它到底是把推理跟控制分开做成两个,还是说端到端的解决是完全放在一起?你觉得这个其实反而不是现在最重要的问题,可能这几种路径都可以,我感觉现在整个机器人模型领域大家的技术路径看起来也是没有统一的。 柯丽一鸣:我觉得这句话非常有意思,我最近在和一个学弟吃饭的时候还在聊,因为大概从三、四年前开始,我们能感知到整个行业是有变化的,之前学术界会更加的散一些,大家的方向、想法、算法还有关注的问题都非常的不一样,而现在自从 VLA 就视觉语言动作模型出世以后,变得流行起来,而且很多人跟进,反而让我觉得现在越来越多的方面开始趋同化了。 泓君:你觉得趋同化表现在哪方面?从哪些各种各样不同的方向变成了同一个方向?这个同指的是什么? 柯丽一鸣:其中之一是模仿学习。我是2018年开始做模仿学习的,那个时候行业研究不多,也没有很多真机的研究可以 follow ,在当时会觉得这是一个不那么主流或者大众的一个想法,2018年当时是已经看到了波士顿这个跳,毕竟人形机器人跳即使到现在直接用模仿学习,可能也是一个比较难的挑战。 业内的很多人开玩笑的时候就会说, 60 年代咱机器人就把人类送上月球了,机器人就朝着火星去了,这是成功的机器人的方法,它就直接变成火箭学科了,只有我们这些机器人研究者还没搞明白它怎么做成功的,还在这里搞机器人,虽然是玩笑,但也说明这个行业内,有一波又一波的接力探索,就包括 2000 年左右自动驾驶的探索,还有后面这些人形机器人,波士顿动力为首的这些力量。 2000 年初,其实还有一个Willow Garage,也是在美国机器人学术界里面比较有名、当时很红火的一家创业公司,当时他们就主推了一个叫PR 2 的机器人,也算是移动、但不是人形机器人的一个老祖宗。所以从之前那个时代看的话,我会觉得大家的研究方向都不一样,有的人做车、有的人做手,这些都是散布在机器人行业里各处的,而现在确实因为大模型的红火,模型的通用性被强调,很多人开始想说能不能把这些东西糅合在一起,这算是一个非常有意思的趋同化的发展吧。 Willow Garage,图片来源:Business Insider 泓君:我看到现在业界,从创业方向看的话,大家又有很多的不一样,比如说有足式机器人,下面是一个人形机器人自己走路的;还有轮式机器人,它可能就注重于手部的操作,走路的部分它用轮子滚就可以了。很多公司也在想,我能不能有一个上半身跟下半身都能同时操作的机器人?因为很多机器人它可能要么上半身,要么下半身,但整体上大家可能都想把模型做得更大、功能做得更通用。 柯丽一鸣:我觉得“同”说的是,很多原来做在不同形态机型上的人,会用不同方法,现在大家都非常的开放,会说我们要不要试一试视觉语言的这种大模型,你说的这种上半身、下半身的形态,其实 π₀.₅做的就是这个事。 泓君:Kay觉得现在整个机器人模型连GPT-2它的水平都不够,王昊你怎么看? 我们现在基本上已经知道:规模化是唯一的可靠路径了,所以我们要在这个阶段,疯狂地积累数据,提升模型规模,同时搭建支持具身智能的各种基础设施,所以说人形机器人目前是已经处于GPT-2的阶段是比较客观的。 图片来源:自变量机器人-已开源的具身智能基础模型WALL-OSS 王昊:现在在谈我们在机器人领域的GPT-2到GPT-3 ,从语言模型来讲,是有一个不一样的地方。当年在做语言模型时候,大家不知道这条路线是否真的可以走通,中间产生了很多分散式的探索又汇聚的过程。现在我们是明确的知道、而且看到了这种规模化带来的提升,所以对于我们来讲,路径和目标更加明确、更加唯一,所以我预测会在1~2年的时间,我们完全可以达到GPT-3的这个水平。 泓君:要1~2年的时间还挺快的。我注意到在美国,我们聊起机器人的话,大家都是想做这种通用机器人,然后再朝一个超大规模的模型做,如果类比于自动驾驶的话,就是美国上来就想做的是L4、L5级的自动驾驶。但是我们看到中国的发展方向,我感觉还是有很多的小而精的创业路线,就好比中国企业在做自动驾驶的时候,首先想到的是能不能在一个园区、一个码头,把这个场景先落地了,做一个非常垂直的小而精的产业。二位怎么看机器人的这两种方式,以及在产业的发展上,最终结果会有什么不一样?哪条路径能跑出来? 王昊:我觉得这个得结合中美各自的优势来看这个问题。确实美国的现在路径就是自上而下的不计成本的,他们会优先做一个接近于AGI的超大模型,有这个基础之后,再去想应该怎么去做。这也是因为美国在算力上的优势,最顶级的芯片、最大量的算力集群都在美国,所以路径更加倾向于用无限的算力,去探索能力的边界。 但中国其实芯片上确实有一定的限制,所以这也倒逼了中国的企业,研究思考在有限的算力下如何实现更高的效率,但说中国企业现在在走小而精的技术路线,我倒不是很同意这一点。 中国其实是拥有全球最大的互联网生态移动应用场景,这个场景优势以及中国在硬件领域拥有非常完善的产业链,这个是美国其实没法比的。其实国内有很多顶尖的研究机构和非常好的创业公司,都是非常深刻地去从第一性原理的角度去思考,非常深刻地去理解Scaling law这件事情,它其实是通往AGI的必经之路。 我们坚信必须得有一个强大的、无所不能的基础模型,才有可能把这基础模型用到各种垂直领域,让它得到更加高效的部署,但这个过程不能反过来,必须得有大而通用的基础,才会有小而精的发展。在实现的路径上,其实国内更像是上下结合,双轨并行,一方面尽可能多的去考虑场景,尤其是考虑这种通用泛化的场景可能带给我们什么,同时又去迭代我们自己的通用基础模型的能力,才能更快地让机器人在现实世界获得更好的反馈,帮助大家实现商业闭环以及开始形成数据飞轮。 图片来源:自变量机器人 王昊:对,我们一定会去做通用的模型,这个是很重要的。 同时,中国制造业摆在那里,机器人确实是有很大的硬件需求,在国内针对商业需求做硬件这个优势,现阶段来看,就没有谁能够比得过国内。因此国内现在的生态里,很多人的创业都是一边保证着商业的成功,一边做一些其他探索。 之前我说自己毕业的这一年比较幸运,因为如果早两年毕业(可能我就做不下去了),当时有很多(早毕业的)朋友,他们机器人研究做得很优秀,可是都转行了,都转去做大语言模型、做强化学习。做机器人能让你锻炼到技术,但并不是做机器人本身,与其说美国很多公司一直都在做大而通用的模型,而不如说是这个时代恰巧让我们在2024年前后,涌现了一批相信这个道路的人。 这个恰巧的因素也是归功于OpenAI把大语言模型这件事做通了,给整个行业的一个反思和震撼。直到现在,我在加入PI的时候,和他们聊天讨论要不要去做,我就在问:你们做人型机器人行吗?你们要做人型的话是不是要烧很多钱?道路怎么走?商业化怎么走?这公司怎么活下来呀?从商业化的角度上来说,其实并不是那么明朗的一件事情,所以我才会感叹这些公司真的是凤毛麟角,能够有这么一个时机成立,能够有人去相信他也许能把事情做成。 而在这样的公司出现之前,其实美国的工业界是有很多机器学习的应用公司的,其中可能比较有名,也和我们公司渊源颇长的一个公司,就是Covariant Robotics,这个是伯克利的一位非常有名的教授所创立的,这些个人的创业的经历启发到了后面的人。因为在外界看来, Covariant就是因为深耕了一个商业的点,所以它商业做成了,但是它通用就没有做得那么好。我们公司最大的目标是想要做通用、想要做数据驱动,所以我们是很小心地避免做一些短期的商业项目,有这么一个历史因素,导致了现在的公司生态是这样。 图片来源:Covariant Robotics 我现在是比较乐观的,因为我觉得机器人领域的发展走在正确的道路上,有了Scaling law这样快速发展的规律,这在整个人类的历史演进中,我都觉得很幸运的事情,因为有一条看起来很明确路径,可以告诉我们怎么做:你只要投入算力和数据、迭代模型的架构、提升机器的能力,那就能肉眼可见地看到机器人的提升。 所以虽然现在有很多问题,让我们觉得很困难,但放在5年后再去看,都是可以被解决的,而且模型一定可以跨越到一个阈值、进入到新的阶段,所以我预测5年这个时间是非常合理的。 另外关于5年这个时间点,其实也需要审慎一点,因为机器人不像纯软件那样可以轻资产快速迭代,机器人还是受限于物理世界的物理定律,硬件得发展,还要全方位突破数据、算法、供应链、商业模式等等因素,才有可能真正做到那个地步。 泓君:我觉得是一个蛮大胆的预测。 另外,我们具身智能行业其实和自动驾驶、甚至火箭升天这些传统的机器人行业有些不一样的地方。我们可能更像扫地机器人,就是最早的扫地机器人其实不完美,需要用户明白它能做什么、不能做什么,这就是一个比较好的商业化典范。以这个为目标的话,我保守估计是需要5~10年做出这样的产品,它可能偶尔会出错,但是它犯的错是在用户的范围里的,这样也能成为一个可以帮到用户的产品。 我有个问题很好奇,有的机器人公司是以“产业化”为目标的,想要做一些商业化应用的东西,这些公司该如何兼顾商业化与研发? 图片来源:自变量机器人 王昊:我觉得这个问题挺好的。因为作为创业公司,从第一天我们就在思考,怎么做既能仰望星空,也能脚踏实地?由于现实的因素,不可能达到AGI再去思考商业化,我们现在的策略就是,尽可能在我们通用模型的基础上,让它进入一些场景里做一些事情,这个场景必须和最终想实现的通用场景是比较接近的、它是可以去泛化的,所以我们尽可能的不去碰那些比较封闭的场景。 像一些公共服务、养老服务的场景就非常好,这样场景和通用机器人的最终应用场景有一些类似的地方,能涉及一些复杂的任务,比如和人的接触,也涉及到没有那么复杂的,比如只是打扫卫生、拿东西、处理食材等等。从这个角度来看,这些就是好的场景,因为和最终的目标接近,你可以在这些场景里,不断地迭代、检验通用模型的能力,也可以获得非常宝贵的数据反馈。但要保持这个选择初心,很重要的一点是:得有很强的商业化路径的定力。 另外一个比较重要的点,是公司的组织能力。因为一个公司的组织能力、组织结构,决定了这个公司的上限,我觉得公司一定要以通用模型、以基础模型作为目标,达到一个完全没有壁垒、高效协同的一个组织,才可能促使你在中间迈出的每一步都不会走错,最终能使你达到终极目标。 泓君:所以你是比较注重训练的场景是否能有商业化应用的,而不是一个在封闭化场景里面就能实现的一个需求。刚刚说的家用机器人帮我们做饭、洗衣、叠被子,这样的使用场景能不能让机器人有足够销量,去养活一个机器人公司? 王昊:我觉得是很有希望的。因为现在整个机器人的产业的规模还没有起来,所以等规模起来后,硬件成本还有非常大的降低空间。随着模型水平的提升、加上硬件成本降低,几年后的价格,会让用户的接受度更高。 其次从这个功能角度来讲,如果我们可以帮普通用户去做很多事,大家会非常乐意接受这样的产品。现在大家难以接受机器人,是因为机器人似乎只能跳跳舞、做一些情绪价值的陪伴,好像没有其他功能,以前机器人没机会向普通用户展示各种应用,但未来我觉得是有很多展示机会的,这个想象的空间是很大的。

Physical Intelligence Frequently Asked Questions (FAQ)

When was Physical Intelligence founded?

Physical Intelligence was founded in 2024.

Where is Physical Intelligence's headquarters?

Physical Intelligence's headquarters is located at 396 Treat Avenue, San Francisco.

What is Physical Intelligence's latest funding round?

Physical Intelligence's latest funding round is Series A.

How much did Physical Intelligence raise?

Physical Intelligence raised a total of $470M.

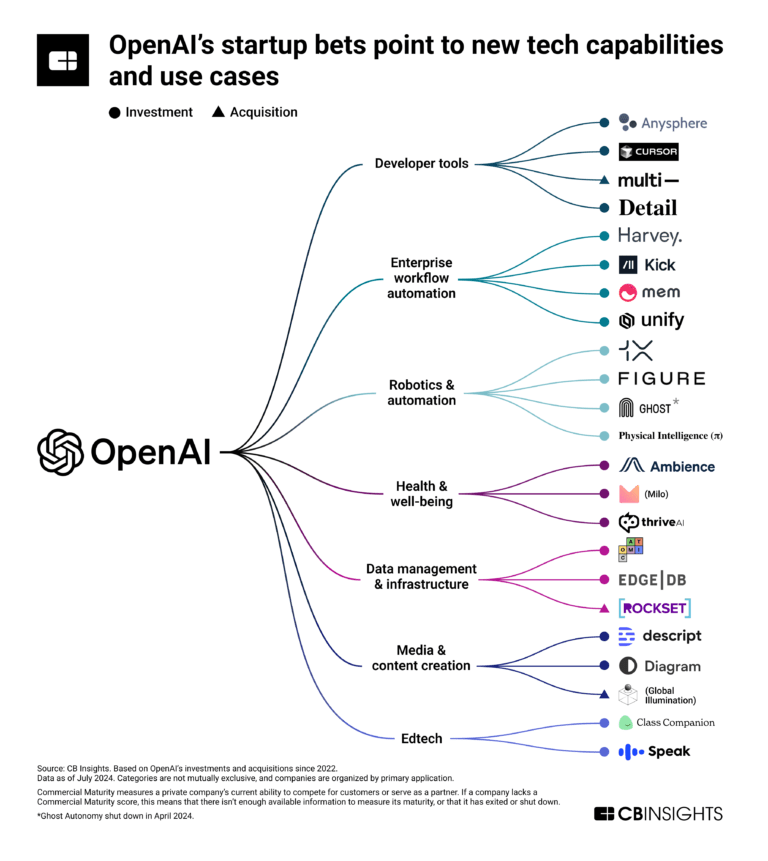

Who are the investors of Physical Intelligence?

Investors of Physical Intelligence include Sequoia Capital, Lux Capital, Khosla Ventures, Thrive Capital, OpenAI Startup Fund and 7 more.

Who are Physical Intelligence's competitors?

Competitors of Physical Intelligence include Skild AI and 5 more.

Loading...

Compare Physical Intelligence to Competitors

Cognitive Engines offers artificial intelligence technology for industrial robotics and healthcare sectors. The company provides AI algorithms. It enables industrial robots to interact with human operators, support physical tasks, and integrate non-digital staff into production processes. It was founded in 2019 and is based in Cestas, France.

Artificialy specializes in the development of artificial intelligence solutions for various sectors. The company offers a range of services, including industrial machine and process optimization, predictive maintenance, customer relationship management, strategic marketing analytics, computer vision, advanced image analysis, text-to-knowledge transformation, and natural language processing chatbots. Its AI solutions aim to support operational tasks and customer service without requiring specialized technical knowledge from the end-user. It was founded in 2020 and is based in Lugano, Switzerland.

Landing AI offers a software platform that provides visual prompting for a range of applications. Its product includes an end-to-end artificial intelligence (AI) platform specifically designed for industrial customers to build and deploy AI visual inspection solutions. The company was founded in 2017 and is based in Palo Alto, California.

SLAMcore specializes in spatial intelligence and operates in the technology sector. It focuses on real-time location systems (RTLS) and autonomous vehicle operation. The company offers products such as Slamcore Aware and Slamcore software development kit (SDK), which provide vision-based positioning and spatial understanding using stereo cameras, inertial sensors, and advanced artificial intelligence (AI) algorithms. Its solutions are designed for tracking and situational awareness in various environments, catering to industries that require robust vehicle and robot localization. It was founded in 2016 and is based in London, United Kingdom.

RGo Robotics specializes in artificial perception technology for mobile robots. The company's main product, the Perception Engine, provides mobile robots with the ability to understand complex surroundings and operate autonomously, similar to human perception. It primarily serves sectors such as warehouse automation, last-mile delivery, outdoor machinery, and service robots. It was founded in 2018 and is based in Cambridge, Massachusetts.

Figure engages in the development of general-purpose humanoid robots. Its main product is a commercially viable autonomous humanoid robot designed to perform a variety of tasks across multiple industries, combining human-like dexterity with advanced artificial intelligence. Its humanoid robots are engineered to support sectors such as manufacturing, logistics, warehousing, and retail. It was founded in 2022 and is based in Sunnyvale, California.

Loading...