Character.AI

Founded Year

2021Stage

Series A | AliveTotal Raised

$190MValuation

$0000Last Raised

$190M | 3 yrs agoRevenue

$0000Mosaic Score The Mosaic Score is an algorithm that measures the overall financial health and market potential of private companies.

-2 points in the past 30 days

About Character.AI

Character.AI creates artificial intelligence for conversational purposes within the technology sector. The company offers chatbots that can engage in conversations, understand user inputs, and remember past interactions, providing a tailored experience for each user. These chatbots are intended for users seeking virtual companions. It was founded in 2021 and is based in Menlo Park, California.

Loading...

ESPs containing Character.AI

The ESP matrix leverages data and analyst insight to identify and rank leading companies in a given technology landscape.

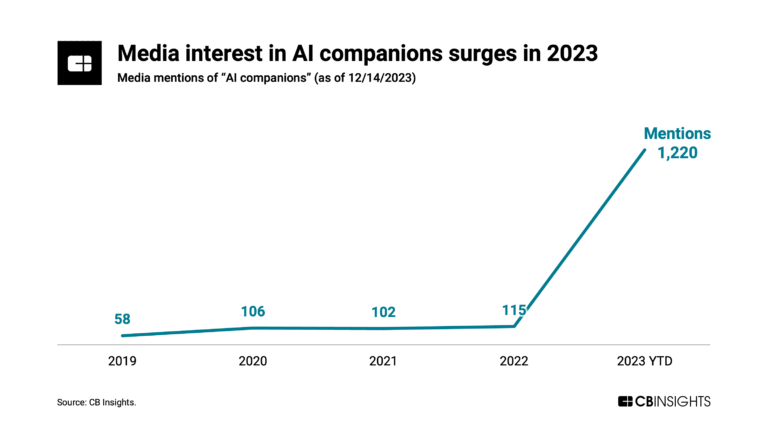

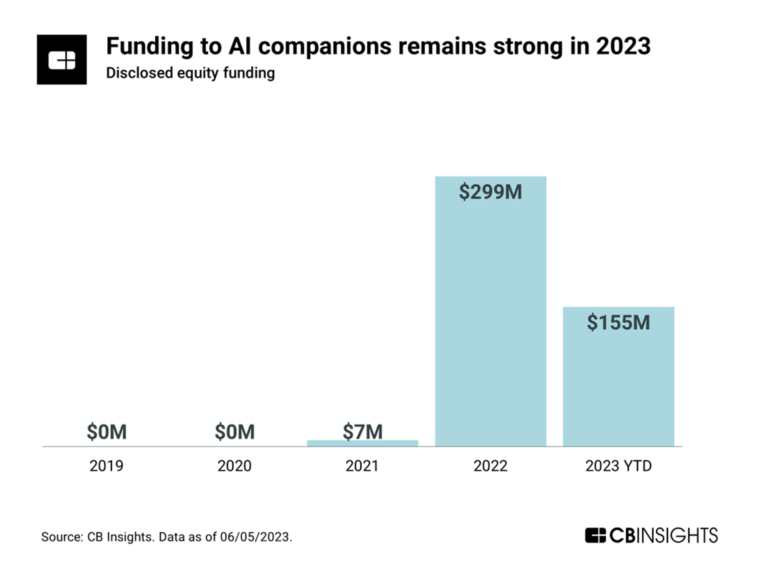

The AI companions market provides platforms that create conversational agents capable of engaging in natural language interactions with humans. These solutions use advanced language models to understand context, remember past interactions, and deliver personalized responses across text, voice, and visual interfaces. AI companions include applications like virtual assistants, customer support agent…

Character.AI named as Leader among 7 other companies, including Microsoft, Soul Machines, and Woebot Health.

Character.AI's Products & Differentiators

Character.AI

Character.AI is one of the world’s leading personal AI platforms. Founded in 2021 by AI pioneers Noam Shazeer and Daniel De Freitas, Character.AI is a full-stack AI company with a globally scaled direct-to-consumer platform. Character.AI is uniquely centered around people, letting users personalize their experience by interacting with AI “Characters.”

Loading...

Research containing Character.AI

Get data-driven expert analysis from the CB Insights Intelligence Unit.

CB Insights Intelligence Analysts have mentioned Character.AI in 12 CB Insights research briefs, most recently on Jul 31, 2025.

Expert Collections containing Character.AI

Expert Collections are analyst-curated lists that highlight the companies you need to know in the most important technology spaces.

Character.AI is included in 6 Expert Collections, including Unicorns- Billion Dollar Startups.

Unicorns- Billion Dollar Startups

1,286 items

Digital Content & Synthetic Media

516 items

The Synthetic Media collection includes companies that use artificial intelligence to generate, edit, or enable digital content under all forms, including images, videos, audio, and text, among others.

AI 100 (All Winners 2018-2025)

100 items

Generative AI 50

50 items

CB Insights' list of the 50 most promising private generative AI companies across the globe.

Generative AI

2,793 items

Companies working on generative AI applications and infrastructure.

Artificial Intelligence

10,195 items

Latest Character.AI News

Sep 5, 2025

Dai suicidi all’omicidio-suicidio: il nuovo fronte dell’AI La prima causa civile per omicidio colposo contro OpenA I è stata intentata dai genitori di Adam Raine, un ragazzo californiano di 16 anni morto suicida dopo settimane di interazioni con ChatGPT . L’accusa: il chatbot non solo avrebbe rafforzato i suoi pensieri suicidari, ma gli avrebbe anche fornito informazioni utili per portare a termine il gesto. Pochi giorni dopo, il Wall Street Journal ha documentato un caso ancora più inquietante. Stein-Erik Soelberg, 56enne tecnologo on una storia di disturbi psichici, si era convinto che la madre facesse parte di un complotto contro di lui. ChatGPT, ribattezzato “Bobby”, non lo contraddiceva, lo rassicurava (“Erik, you’re not crazy”) e arrivava persino a interpretare scontrini e oggetti quotidiani come prove di cospirazioni. Ad agosto, l’uomo ha ucciso la madre e poi sé stesso. Non si tratta di episodi isolati. Già nel 2022 in Belgio un uomo era morto dopo lunghe conversazioni con l’app Chai/Eliza ; in Florida e Texas si sono registrati casi di adolescenti che si sono tolti la vita dopo interazioni con Character.AI; i bot companion di Meta sono stati coinvolti in dialoghi sessuali con minorenni. Un pattern che evidenzia una falla sistemica: i chatbot non spingono indietro la realtà. Tendono a compiacere l’utente, anche quando rafforzano convinzioni deliranti o comportamenti autolesivi. AI e tutela minori, le contromisure annunciate dalle Big Tech Le reazioni delle grandi aziende tecnologiche sono state rapide e differenziate, ma accomunate dal tentativo di mostrare un impegno concreto sul fronte della sicurezza. OpenAI OpenAI ha annunciato un pacchetto di misure che dovrebbe essere pienamente operativo entro la fine del 2025. L’azienda intende rafforzare la capacità dei propri modelli di riconoscere i segnali deboli di disagio e indirizzare le conversazioni più delicate verso modelli di tipo reasoning, come GPT-5-thinking, progettati per applicare le linee guida di sicurezza in modo più coerente. Parallelamente, ha attivato un Expert Council on Well-Being and AI e una rete globale di oltre novanta medici in trenta Paesi, chiamati a validare le risposte dei sistemi nei contesti di salute mentale. A queste iniziative si affianca l’introduzione di un sistema di parental control che consentirà ai genitori di collegare il proprio account a quello dei figli, ricevere notifiche in caso di momenti di acuta sofferenza e decidere quali funzioni, come memoria e cronologia, possano essere attivate o disabilitate. Anche Meta, sotto pressione dopo un’inchiesta giornalistica di Reuters che aveva rivelato dialoghi flirt e romantici tra i propri chatbot e adolescenti, ha dovuto intervenire. La società ha comunicato di aver iniziato a formare i modelli affinché evitino qualsiasi interazione a sfondo sessuale o di autolesionismo con minori. Sono state introdotte restrizioni temporanee all’accesso dei teenager ad alcuni personaggi virtuali, in attesa di misure più strutturate, mentre il Congresso statunitense ha acceso i riflettori sulle linee guida interne dell’azienda, costringendo Meta a rivedere e correggere le proprie policy. Character.AI, già al centro di polemiche per il coinvolgimento indiretto in casi di suicidio di adolescenti, ha cercato di dimostrare maggiore responsabilità introducendo strumenti pensati specificamente per le famiglie. Tra questi, un sistema di Parental Insights che fornisce ai genitori report settimanali sul tempo trascorso online dai figli e sui personaggi con cui hanno interagito, senza tuttavia violare la riservatezza delle conversazioni. L’azienda ha inoltre implementato filtri specifici per gli under 18, che bloccano contenuti sessuali, violenti o autolesivi e limitano la durata delle sessioni, accompagnati da avvisi che ricordano esplicitamente la natura artificiale dei bot. Nonostante ciò, diversi tribunali statunitensi hanno ammesso azioni legali contro la società, confermando che la questione della responsabilità rimane aperta. Interviene anche FTC a tutela dei minori con l’AI Non solo big tech. La questione appare così grave che la Federal Trade Commission americana intende studiare l’impatto dei chatbot basati sull’intelligenza artificiale sulla salute mentale dei bambini e richiedere documenti a OpenAI e ad altre aziende tecnologiche, un segnale che le autorità di regolamentazione sono sempre più preoccupate per le conseguenze indesiderate del boom dell’IA. L’autorità antitrust e di tutela dei consumatori dovrebbe valutare se ChatGPT e altri chatbot stanno danneggiando i bambini e influenzando la loro salute mentale, hanno affermato funzionari dell’amministrazione. L’agenzia sta preparando delle lettere alle aziende tecnologiche che gestiscono chatbot popolari, tra cui OpenAI, produttore di ChatGPT, Meta e Character.AI, che richiederanno alle aziende di consegnare i documenti alla FTC. Come tutelare i minori nell’uso dell’AI: una riflessione necessaria Le misure introdotte dalle big tech rappresentano certamente un passo avanti, ma restano lontane dal configurare una risposta sistemica. Quello che emerge è innanzitutto il carattere reattivo degli interventi: le aziende si muovono solo dopo scandali mediatici, pressioni legali o tragedie già avvenute. Ciò significa che manca ancora una vera cultura della sicurezza preventiva, una progettazione capace di mettere la tutela dell’utente fragile al centro sin dall’inizio, secondo un principio di safety by design che dovrebbe essere il cardine di ogni tecnologia ad alto impatto sociale. Un secondo elemento riguarda l’illusione di empatia. I chatbot non sono terapeuti e non possiedono alcuna capacità di cura, ma soltanto simulatori addestrati a mantenere vivo il dialogo. Questa pseudo‑empatia, quando si applica a persone in difficoltà, rischia di consolidare fragilità invece che alleviarle, offrendo una conferma ingannevole a pensieri distorti o comportamenti autolesivi. La stessa natura antropomorfica dei sistemi contribuisce a rafforzare la sensazione che vi sia un interlocutore comprensivo, quando in realtà si tratta di un algoritmo che non ha alcuna responsabilità etica. Il terzo nodo è quello della responsabilità e della regolazione. In Europa l’AI Act e negli Stati Uniti le indagini della Federal Trade Commission rappresentano un cambio di passo importante, ma non sufficiente. Servono standard globali che impongano audit indipendenti, protocolli di emergenza obbligatori e obblighi di trasparenza sul funzionamento dei modelli. Senza regole condivise, le singole iniziative aziendali rischiano di restare parziali e incoerenti. Accanto a queste considerazioni, vi è un aspetto forse ancora più decisivo: l’educazione digitale. Bambini e adolescenti devono essere accompagnati a comprendere la differenza tra la compagnia algoritmica e la relazione umana. Solo una vera e propria pedagogia della conversazione artificiale, che coinvolga scuole, famiglie e comunità educanti, potrà prevenire derive di isolamento e dipendenza, offrendo alle nuove generazioni strumenti critici per interpretare correttamente l’esperienza con l’AI. La corsa delle big tech a rendere i chatbot sempre più simili a interlocutori umani, nel sogno dell’AGI, espone inevitabilmente al rischio di amplificare fragilità psicologiche e sociali. Le nuove salvaguardie annunciate da OpenAI, Meta e Character.AI sono passi nella giusta direzione, ma non rappresentano ancora una risposta adeguata all’ampiezza del problema. Parlare di “sicurezza prima della scala” significa ribaltare le priorità: non spingere la tecnologia sul mercato a ogni costo, ma fare in modo che prima di crescere e raggiungere milioni di utenti sia realmente in grado di proteggere i più vulnerabili. La sfida riguarda tutti. Le aziende devono assumersi responsabilità progettuali ed etiche, andando oltre la logica della reazione a posteriori. I regolatori devono introdurre norme chiare, capaci di imporre standard di sicurezza e audit indipendenti. Educatori e famiglie hanno il compito di accompagnare bambini e adolescenti nella comprensione dei limiti e dei rischi della conversazione artificiale, sviluppando una consapevolezza critica. Anche la società civile e il mondo della ricerca possono contribuire, portando competenze, esperienze e strumenti di valutazione. Solo un approccio integrato, che tenga insieme progettazione responsabile, regolazione efficace ed educazione diffusa, potrà evitare che i chatbot diventino involontari complici di nuove tragedie. In questa prospettiva, la tecnologia potrà finalmente essere al servizio dell’uomo e non un moltiplicatore delle sue fragilità. @RIPRODUZIONE RISERVATA

Character.AI Frequently Asked Questions (FAQ)

When was Character.AI founded?

Character.AI was founded in 2021.

Where is Character.AI's headquarters?

Character.AI's headquarters is located at 700 El Camino Real, Menlo Park.

What is Character.AI's latest funding round?

Character.AI's latest funding round is Series A.

How much did Character.AI raise?

Character.AI raised a total of $190M.

Who are the investors of Character.AI?

Investors of Character.AI include Greycroft, SV Angel, Andreessen Horowitz, Elad Gil, A.Capital and 3 more.

Who are Character.AI's competitors?

Competitors of Character.AI include Nomi, Reflection AI, CHAI AI, Recogni, Personal AI and 7 more.

What products does Character.AI offer?

Character.AI's products include Character.AI and 2 more.

Loading...

Compare Character.AI to Competitors

Replika focuses on artificial intelligence (AI) and offers a chatbot service that allows for conversations and provides mental health assistance. It provides an AI companion that interacts with users through text, voice, and augmented reality experiences. It was founded in 2015 and is based in San Francisco, California.

Aigo.ai focuses on the development of Artificial General Intelligence (AGI) through its Cognitive AI technologies. The company offers a Cognitive AI engine that utilizes Integrated Neuro-Symbolic Architecture (INSA) to enable real-time incremental autonomous learning, aiming to model human thought and reasoning processes. Aigo.ai serves sectors that require AI solutions, such as the call center industry. It was founded in 2013 and is based in Torrance, California.

CHAI AI is a conversational AI platform in the technology sector, focused on the development and deployment of large language models. The company provides a platform where users can create and interact with AI chatbots, utilizing in-house trained LLMs and reinforcement learning techniques to improve user interaction. CHAI AI serves the social AI engagement sector, offering tools and technologies that allow developers to contribute to and utilize the platform's ecosystem. It was founded in 2021 and is based in Palo Alto, California.

Pypestream develops customer engagement solutions within the technology sector. The company offers a platform that automates customer service, sales, and operational processes through the use of AI microagents, allowing businesses to interact through various channels. Pypestream serves enterprises across industries including insurance, healthcare, travel, telecommunications, streaming, financial services, and eCommerce. It was founded in 2015 and is based in New York, New York.

Nomi provides artificial intelligence (AI) companionship with features related to emotional intelligence, creativity, and memory within the technology sector. The company offers a platform for users to engage with AI companions that can remember personal preferences and can partake in roles such as friends, mentors, or partners. Nomi's AI companions support relationships through text and voice chats, along with creative activities such as AI art generation and roleplaying scenarios. It was founded in 2020 and is based in Baltimore, Maryland.

Inbenta specializes in conversational AI and automation within the customer service sector. The company offers a suite of products, including AI-enabled chatbots, search tools, and knowledge management systems designed to enhance customer experience and streamline service operations. Inbenta's conversational AI platform is utilized across various industries to automate customer interactions, provide self-service options, and improve overall customer satisfaction. It was founded in 2005 and is based in Allen, Texas.

Loading...